2022年の爆発的な生成AIブームを契機に、サービス・ビジネス・娯楽といった私たちの生活における様々な分野で生成AIが活用されるようなりました。生成AIを活用することで、より多くの人がクリエイティブ活動に参画できるようになったのです。

生成AIを利用することで多くのメリットを享受できる一方で、生成AIの成り立ちやメカニズムに由来した数多くのデメリットがあることはご存じでしょうか?このデメリットがSNS炎上を引き起こし、ブランドイメージの低下を引き起こすリスクがあることも事実です。

本記事では、生成AIの利用時に気を付けるべきSNS炎上リスクと、その解決策について解説いたします。

また、「生成AIの利用時には、最低限のリスク回避は行えるようにしたい」とお考えのご担当者さまに向けて、ホワイトペーパー「生成AIリスクチェックシート《企業編》」をご提供しております。ぜひ本記事と併せて、今後の生成AI利用とリスク回避にお役立てください。

目次

生成AI利用の基礎

まず、生成AIとはどのようなものなのでしょうか?

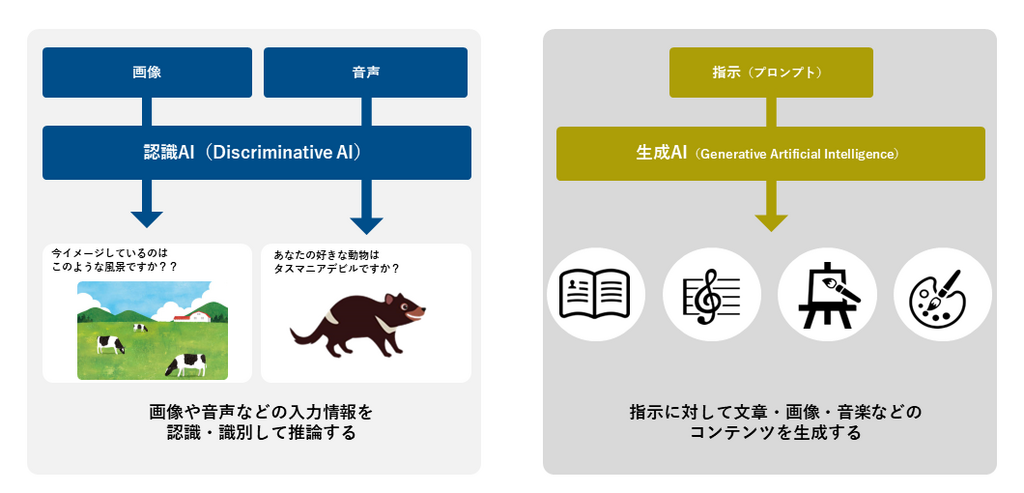

生成AIとは、大量の学習で得られたパターンや構造をもとに、新しいデータを生成することの出来る情報処理システムのことを指します。具体的には、「プロンプト」と呼ばれる指示文を入力することによって、文章やプログラムコード・画像・音声・動画など様々なコンテンツを生成することができるのです。

有名どころだと、2022年11月にリリースされた「ChatGPT」や「LaMBDA」「NovelAI」「Llama2」。画像生成AIであれば「Stable Diffusion」や「Adobe Firefly」などがあげられます。

「認知AI」と「生成AI」の違いとは?

これまで一般的にAI(人工知能)と呼ばれてきたものは「認識AI」と呼ばれるものであり、与えられたデータや情報を理解し、それを解析したり分類することに特化したAIでした。

しかし、「生成AI」は従来の認識AIと異なり、さまざまなコンテンツを生み出すことが可能な生産性の高いシステムです。プロンプト(指示文)を認識するだけではなく、解析をおこなって適切なコンテンツを生成出来るので、まさに認識AIが進化したものと呼べるでしょう。

生成AIの利用によるメリットとは?

生成AIの利用には主に4つのメリットが挙げられます。

コストを削減して生産性を高められる

生成AIは、膨大な量のコンテンツを即座に生成することが出来ます。また、大量のデータを高速で処理するとともに、24時間365日の連続稼働にも耐えうる耐久性があるため、人力と比較してタイム・コストパフォーマンスに圧倒的なアドバンテージのあることがメリットの一つとしてあげられます。

クオリティの担保

生成AIでは入力されるプロンプト(指示文)によってクオリティ自体は左右されてしまいます。しかし、生成AIはストックされている大量の学習データによって最低限のクオリティが担保されているため、どんなに拙いプロンプトを入力したとしても、質の高いコンテンツを作ることが出来るのです。

幅広いコンテンツの生成が出来る

生成AIでは文章のみならず、画像・音楽・などありとあらゆるコンテンツを生成することが出来るため、タスクに対して局所的に使用するのではなく、汎用的に利用することが出来ます。

利用ハードルが低い

生成AIとは、基本的にプロンプト入力出来れば誰でも使用することが可能です。そのため、時間のかかる利用研修などをする必要もなく、低コストで導入することが可能なこともメリットの一つとしてあげられます。

生成AIで懸念されている炎上リスクとは?

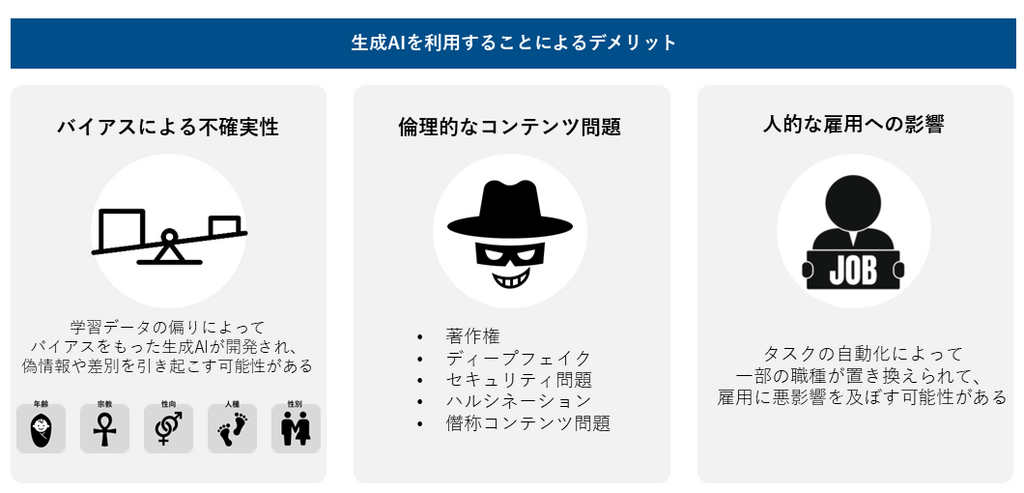

メリットが多い一方で、インシデントに繋がりかねないデメリットが多いことも生成AIの特徴になります。

倫理的なコンテンツリスク

コンテンツの倫理に関わるリスクは特に数多く存在するため、生成AIの利用時には以下のデメリットに注意する必要があります。

著作権に関するリスク

生成AIと著作権の問題は、生成AIの普及という面において最大の壁となっています。著作権と生成AIに関しては主に3つの論題があげられており、SNSやネットのみならず、政府の間でも多くの議論が交わされています。

生成AIの開発や学習に他人の著作物を無断で使用した場合、著作権侵害になるのか?

生成AIの開発は、大量のコンテンツデータをプログラムに学習することでおこなわれています。これによって、学習したデータをベース、または応用することによって様々なコンテンツを生成することが出来るのです。ここで注目したいことは、「生成AIの学習時に他人の著作物を無許可で使用した場合、著作権侵害にあたるのではないか」という疑問です。

現行の著作権法だと、他人の著作物を無断で使用することは原則的に著作権の侵害にあたります。しかし生成AIの開発や学習ではその限りではありません。著作権法(第30条の4)には「柔軟な権利制限規定」というルールが定められています。この規定を解釈すると、「著作物を生成AIの学習用データとして収集・複製し、学習用データセットを作成すること」また「データセットを利用して、生成AIを開発すること」著作権の侵害にあたらないとされています。

簡単に言い換えると、「他人の著作物を生成AIのために使うことは、著作権法のイレギュラー規定に法り、基本的には著作権侵害にはあたらない」ということです。

生成AIで生み出されたコンテンツに著作権は付与されるのか?

生成AIとは「簡単な指示文(プロンプト)を入力することで、誰でもコンテンツが生成できる」ものです。一方でコンテンツが著作物にあたる前提条件として、「創作的であること」という項目が存在します。これは、作った人の個性が多少なりとも表れているものという意味です。

では、「簡単なプロンプトを入力する」という行為は、果たして「創作」にあたるのでしょうか?それによって生成されたコンテンツは「著作物」になり得るのでしょうか?

これについては、AI生成物であっても、人間による「創作意図」と「創作的寄与」が認められた場合のみ著作物と認められるとされています。なお、創作的寄与とは以下のことを指します。

- 指示・入力(プロンプト)の分量や内容

- 生成の試行回数

- 複数の生成物からの選択

- 生成後の加筆修正

つまり、簡単なプロンプトを入力してAIで生成されたコンテンツは著作物ではないということになります。

AI生成物が既存の著作物と似通っていた場合。著作権侵害になってしまうか?

では、生成AIを利用して生み出されたコンテンツが既存の著作物に似ていた場合、著作権侵害になってしまうのでしょうか?

この問題に関しては現行の著作権法のとおり、「依拠性」(既存の著作物をもとにして作られたかどうか)と「類似性」(後発の作品が既存の著作物と同一、または似ていること)の両方を満たしていると認められて初めて成り立つものとされているため、AI生成物と言えどその原則は変わりません。

では、この依拠性と類似性が認められるのはどの程度なのかというと、日本では、生成AIの著作権侵害に関する判例がほとんどないため、裁判所によって判断が異なるというのが現状です。そのため、個々人でAI生成物が著作権侵害かどうかを判断することは非常に難しい問題とされています。

ディープフェイクに利用されるリスク

ディープフェイクとは、「ディープラーニング(生成AI開発時の深層学習のこと)」と「フェイク(偽・ウソ)」を組み合わせた造語で、生成AIを用いて人物の画像や音声などを人工的に合成する技術のことを指します。例えば、ディープフェイクの技術を用いて、自分の声を他人とそっくりに加工するなどが可能になります。

単語だけ聞くとネガティブな印象を受けがちなディープフェイクですが、それ自体は不正なものではなく、動画配信サービスやSNSといったエンタメビジネスの分野では積極的に取り入れられてもいます。問題とされているのは、ディープいフェイクを悪用した「詐欺行為」や「不正認証」などです。

ディープフェイクの技術を利用して生成されたフェイク音声や映像などを使用して、他人へのなりすましが安易に出来るようになってしまうというセキュリティリスクは大きな課題として挙げられています。実際、2023年11月には日本国首相のディープフェイクが大手動画配信サイトに出回り、大問題となりました。

セキュリティに関するリスク

生成AIの利用に孕むセキュリティ問題には主に2つの課題が挙げられます。

軽率な個人情報の入力による情報漏えい

生成AIには、指示文として入力されたプロンプトを再学習する機能があります。そのためプロンプトを入力する際、安易に機密情報や個人情報を入れてしまうと、生成AIはその情報を再学習してしまい、場合によってはAI生成物として情報漏えいしてしまうリスクを孕んでいます。

不正プログラム混入のリスク

AIが生成したソースコードの中に不正プログラムが混入していた場合(バックドア)、コンピューターウィルスやスパイウェアなどに感染してしまい、甚大な被害をもたらす可能性が懸念されます。

ハルシネーションが発生するリスク

ときに生成AIは、実際には存在しない・確認できない情報を含んだコンテンツを生成することがあります。特に文章で顕著な傾向です。この現象はハルシネーション(幻覚)と呼ばれており、AI生成物を利用する際の大きなネックとなっています。

ハルシネーションが生成されてしまう大きな要因として、生成AIは学習したデータの真偽を確かめないまま平等に扱ってしまうため、結果的に誤情報を学習して生成に利用されてしまうから、とされています。

ハルシネーションはAI利用の信用問題に関する大きな課題です。特に情報が人の人生に大きな影響を与えうる場面(医療・法律・金融など)での生成AIの利用には、慎重になる必要があると言えるでしょう。

僭称コンテンツに関するリスク

僭称コンテンツとは、「人間が創作した」と偽って公表されたAI生成物のことを指します。『生成AIで生み出されたコンテンツに著作権は付与されるのか?』でも解説した通り、AIで生成されたコンテンツは創作過程において「創作意図」と「創作的寄与」が認められない限り、機械(AI)が自律的につくった生成物とみなされるため、著作権は発生しません。しかし、僭称コンテンツは「人間が創作した」と偽っているため、僭称コンテンツを用いて著作権を主張することがまかり通ってしまう恐れがあります。

また、これによって、既存の著作物に対して「自分の著作物が先に出来ていた著作権の侵害だ!」というように、不正な著作権の主張をおこない金銭の要求をするなど、詐欺行為が発生するリスクも懸念されます。

バイアスによる不確実性

AI生成物は「バイアス(先入観・偏り・偏見)」を多分に含む場合があります。なぜかというと、生成AIが性別・人種・宗教・年齢・性向などに基づくバイアスを含んだ情報を学習した結果、それをもとに生成されたコンテンツにもバイアスのかかってしまうからです。

実際の事例として、生成AIを利用して人事評価をおこなったところ、男性優位・学歴優位・顔重視といったバイアスのかかった評価となってしまったケースがあります。もし、社外に公表すべきデータの生成や取捨選択をAIに任せっきりにした場合、バイアスのかかった情報が拡散されてしまい、炎上を引き起こすリスクも多いに懸念されます。

人的な雇用に関するリスク

人的な雇用とは「生成AIに仕事を奪われた結果、職を追われてしまうのでは」という懸念が高まっていることを指します。

実際問題アメリカでは2023年の1~8月にかけて、AIによって失業した(いわゆるAI失業)者は約4000名にのぼるとされています。また、日本の大手企業でも、広告コンテンツの作成に生成AIを導入した結果、ディレクターが30名以上解雇されてしまったというニュースが話題になりました。

生成AIによるSNS炎上事例解説

ここまで生成AIのメリット・デメリットを詳しく解説してまりました。では、生成AIによってどのようなSNS炎上が発生しているのでしょうか?実際の事例で追っていきます。

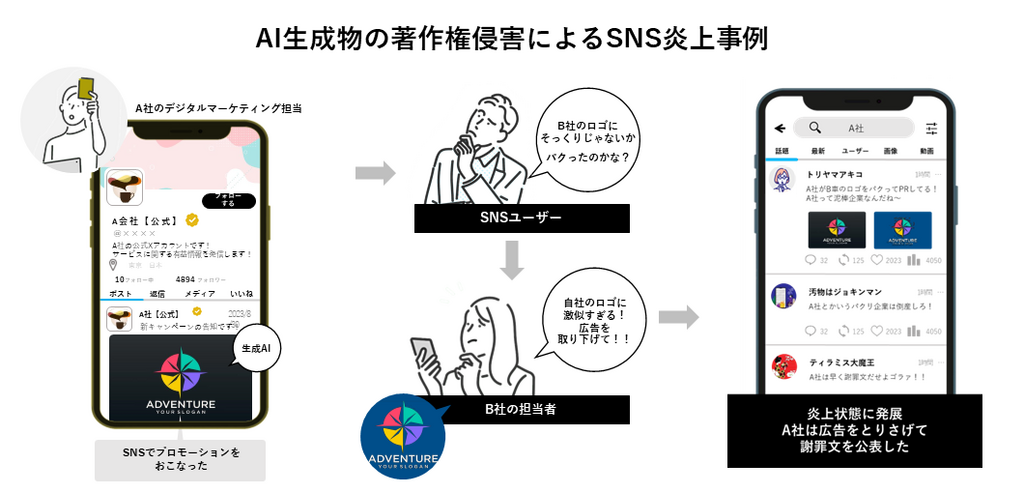

AI生成物の著作権侵害によるSNS炎上事例

炎上の経緯

ある企業(A社)のデジタルマーケティング担当者が、SNSにキャンペーンの告知をするためにイラストをAIで生成しました。

しかし、いざSNS広告を回し始めたところ、複数のユーザーから「別企業(B社)のロゴにそっくりだ。パクリなのではないか?」という問合せが殺到する事態となります。同じく問合せのあったであろうB社からも「自社のロゴに類似しているため、ただちに広告を取り下げて欲しい」という連絡が来てしまいました。

ところが、A社にはこのようなインシデントが発生した場合のエスカレーションフローが作成されていませんでした。A社の担当者は対応に困ったため上長に相談しますが、明確な回答が得られなかったために対応が後手に回ってしまいます。

そうこうしているうちに、この「ロゴそっくり問題」がSNSユーザーの間で徐々に話題となり、ついには炎上状態に突入。対応を疎かにしていたA社は炎上状態になってから、やっとSNS広告を取り下げ、謝罪文を公表する結果となりました。

炎上のポイント

本炎上のポイントは、「そっくり広告が本当に著作権侵害だから炎上が発生したわけではない」という点にあります。

前提としてAI生成物による著作権侵害には「依拠性」と「類似性」が両方ともに認められる必要があります。AI生成物の「依拠性」は「プロンプトとして既存の著作物をそのまま入力した」という場合であればすんなりと認められる可能性は高いです。しかし、如何せん日本での生成AIに関する判例が少ないため、識者によって見解も異なります。全ては裁判所のジャッジ次第であり、簡単に著作権の侵害は認められないという場合も多くあります。

一方で、日本における著作権の具体的な認知度は曖昧だ、というユーザーが大多数を占めているという事実があります。株式会社クロスマーケティングによる著作権認知に関する調査データによると、20%弱のユーザーが「言葉だけ知っている」「全く知らない」と回答しており、「なんとなく知っている」という曖昧なユーザーが70%弱を占める結果となっています。つまり、大半のユーザーがなんとなくレベルの曖昧な知識なため、意見に信頼性が伴っておらず、的外れな主張となっているケースが多く見受けられるのです。その場合、著作権法上は問題ないレベルの共通点があったとしても、ユーザーの思い違いや先入観、または発信するユーザーの影響力(インフルエンサーなど)によっては、著作権侵害だときめつけられてしまい、勢いのまま炎上への発展してしまうケースも無きにしも非ずなのです。

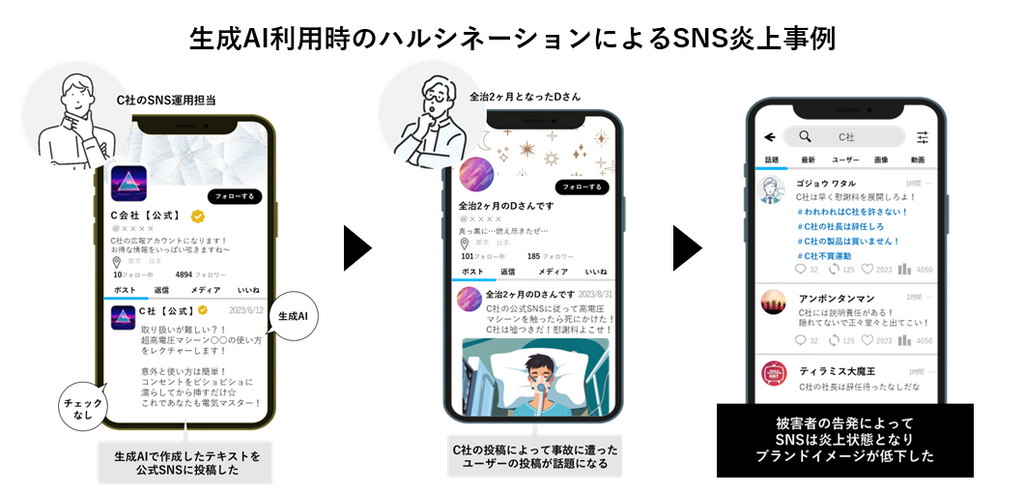

生成AI利用時のハルシネーションによるSNS炎上事例

炎上の経緯

ある企業(C社)の公式SNS担当者が、取扱注意である自社製品の使い方について投稿しました。SNS担当者は、AIを利用して投稿する文章を生成したのですが、ここでハルシネーションが発生してしまい、誤った使い方の文章が生成されてしまいました。SNS担当者はその文章をしっかりとチェックすることなく、そのまま投稿してしまいます。

後日、その投稿をみたSNSユーザー(Dさん)が、公式SNSアカウントが投稿した通りに製品を扱ったところ、命にかかわるような大怪我を負ってしまいました。怪我をしたSNSユーザーは事の顛末をSNSで告発し、企業は炎上状態となってしまいました。

炎上のポイント

本炎上が発生した原因は、生成AIを利用したSNS担当者が生成されたコンテンツの真偽を確認しなかったことにあります。

ハルシネーションの項でも解説した通り、生成AIは情報の真偽を問わずに等しく学習してしまうため、存在しない情報や偽コンテンツを生成してしまう場合があります。現状では、偽情報を生成してしまう事態を避ける手立てはないため、生成AIの利用者自身が生成コンテンツの真偽を逐一チェックしていく必要があるのです。

また、AI生成物のチェック時において、「正しい情報をネット上で求めようとする行為」にも気を付ける必要があります。なぜなら、ネット上の情報とは全てが正しいものとは限らないからです。そのため、正しい情報を得ようとする場合には、ある程度信頼できるソース元から情報をサーベイすることが大切です。例えば、政府や企業が発信している公式情報などがそれにあたります。まちがってもSNSで拾ってきた、ソース不明の情報を鵜呑みにしてはいけません。

生成AIの利用時に気を付けるべきこととは?

事例やデメリットの項でも解説した通り、「生成AIで生み出されるコンテンツは正解とは限りません。」そのため、AIによって生成されたコンテンツは、私たち人間がしっかりとチェックし、矛盾や真偽を問うていく必要があるのです。

ジールコミュニケーションズが配布している資料『生成AIリスクチェックシート《企業編》』では、生成AI利用時に確認すべきチェック項目をポイントと一緒にまとめてあります。安全な生成AIの利用のみならず、生成AIのノウハウについても学べる一石二鳥の資料となっておりますので、ぜひダウンロードいただいた上で今後のリスク対策にお役立て下さい。